|

Жасанды зерденің жалған сөйлегенін әшкерелеудің жолы табылды

|

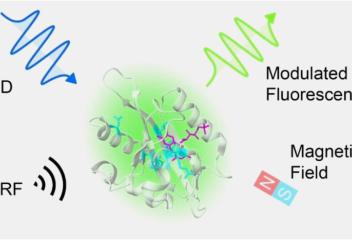

Британдық ғалымдар жасанды зерде (AI) чат-боттарының қалай жалған сөйлейтінін дәл анықтаудың жолын тапты. Бұл жайында islam.kz порталы Nature мерзімді басылымына сілтеме жасай отырып мәлім етеді. Сарапшылардың пікірінше, конфабуляция терминін чат-боттардың жұмыс істеу принципіне қолдануға болады – бұл арада нақты фактілер толығымен жалған оқиғалармен біріктірілген естеліктерді жаңғыртуға қамтитын ұғым турасында сөз болып отыр. Ғалымдар жаңа талдау әдісін қолдана отырып, AI-ның өтірікке жол бергенін әшкерелеудің жолын тапты. ChatGPT және соған ұқсас құралдар шын мәнінде сарапшылар мен құрастырушылар тарапынан жалған сөйлей алмайтыны айтылған, алайда, оларда барлық ақпарат болмаса, олар өз «ойынан» деректерді шығара алады. Сондай-ақ, көптеген сауалдарға түрліше жауап беруге болады, ал бұл жайт статистикалық нақты емес ақпараттарды тудыруы мүмкін. Мұндай кереғарлық жағдай чатбот дұрыс жауапты қалай тұжырымдау керектігін білмеген кезде немесе жауапты негізінен білмеген кезде пайда болады. Ғалымдар семантикалық энтропия (энтропия – бұл реттілік өлшемі, хаос өлшемі. Оның шамасы жүйенің реттелген, құрылған күйден алыс екенін және толығымен хаостық, құрылымсыз, біртекті түрге жақын екенін көрсетеді - znanija.com дерек көзінен) деп атайтын құбылысқа назар аудара отырып, AI-ға бір сұрақты бірнеше рет қояды, содан кейін қанша жауаптың мағыналық жағынан дұрыс жауапқа қаншалықты сай келетінін анықтайды. Егер үлкен сан (яғни, жауаптардың көпшіліг) бірдей мағынаға ие болса, онда AI моделі жауабы дұрыс болса да өзі қалыптастырған тұжырымға сенімді емесін білдіреді. Міне, осындай кезде чатбот жалған сөйлеуі мүмкін.

Ұқсас материал:

«Жасaнды зерде... алдауды үйренді» (https://islam.kz/kk/news/arturli/jasandy-zerde-aldaudy-uirendi-20362/#gsc.tab=0)